Odtwarzalność (badania naukowe)

Odtwarzalność, inaczej reprodukowalność, wraz z pojęciami pokrewnymi takimi, jak powielalność (replikowalność) i powtarzalność (zdolność repetycyjna)[1][2][3][4][5][6][7][8] – to miary z zakresu metodologii nauk oraz statystyki, stosowane przy weryfikowaniu uczciwości badacza lub zespołu badawczego oraz rzetelności badań poprzez odtworzenie ich wyników w badaniach powtórzonych (przez pierwotnego badacza lub zespół badawczy) albo powielonych (przez innego, niezależnego badacza lub zespół badawczy), w ramach ustawicznego procesu autokorygującego w metodzie badawczej. Słowami filozofa nauki Karla Poppera „niepowtarzalne, jednostkowe wydarzenia nie mają dla nauki żadnego znaczenia”[9]. Statystyk Ronald Fisher napisał: „możemy uznać, że zjawisko jest udowodnione eksperymentalnie wówczas, gdy wiemy, jak przeprowadzić eksperyment, który rzadko zawiedzie w wykazaniu istotnych statystycznie rezultatów.”[10]

Przekonujące powielenie powinno w miarę możliwości maksymalnie wiernie odtwarzać warunki i narzędzia, jakie zastosowano w oryginalnym badaniu. Dodatkowo, powinno cechować się wysoką mocą statystyczną i transparentnością. W przypadku gdy projekt pierwotnego badania jest uznany za wadliwy, można również przeprowadzić powielenie konceptualne, rozszerzające oryginalny cel i wyniki, przy użyciu lepszych narzędzi[11][12].

W standardowej procedurze weryfikacji hipotez statystycznych w podejściu częstościowym, z samej definicji progu istotności 5% wynika, że 5% wyników przekracza go przez przypadek. W praktyce założenia modeli statystycznych i metodologii badań mogą nie być dokładnie przestrzegane, w związku z czym liczba „fałszywych alarmów” może być wyższa, niż sugeruje ta nominalna wartość. Z tego powodu wartość dowodowa nieodtworzonych badań jest silnie ograniczona.

Narzędziem, które służy agregacji danych i wyników ze zbioru powieleń jest metaanaliza. Pozwala ona na zbiorcze rozpatrzenie wartości dowodowej badań, oraz wykrycie tendencyjności publikacji[13].

Kryzys odtwarzalności

[edytuj | edytuj kod]Presja instytucjonalna wywierana na badaczy, gdy ocena ich pracy uzależniona jest od takich kryteriów, jak liczba publikacji i istotnych statystycznie wyników, zachęca naukowców do nadużywania metod weryfikacji hipotez statystycznych. W ocenie Gelmana, wskutek niezrozumienia lub celowego naruszania zasad metodologii, badacze i wydawcy czasopism naukowych przywiązywali w praktyce nadmierną wagę do uzyskiwania wyników istotnych statystycznie, niezależnie od tego czy są one prawdziwe, czy nie[14]. Badania które przekroczyły ten próg były publikowane kilkukrotnie częściej[15]. Biagioli, opisując ten problem, nawiązał do prawa Goodharta: ocena pracy naukowej skupiona na prostych wskaźnikach, takich jak istotność statystyczna, sprawia, że zaczynają być one traktowane jak cel sam w sobie, i podważa wiarygodność i rzetelność nauki[16]. Jak zademonstrował zespół statystyków w 2011, przy pomocy zbioru różnego rodzaju drobnych nadużyć metodologicznych, można uzyskać istotność statystyczną na nominalnym poziomie 5%, przy realnym prawdopodobieństwie błędu I rodzaju ponad 50%[17].

W latach 2010. opublikowano szereg badań i raportów, sugerujących że zjawisko to ma poważną skalę, i wymaga ściślejszego traktowania. W ankiecie obejmującej ok. 1500 naukowców z różnych dziedzin, 90% respondentów stwierdziło, że nauki są dotknięte kryzysem odtwarzalności – większość opublikowanych wyników nie jest ponownie testowana, a jeśli do tego dochodzi, wyników często nie udaje się odtworzyć[18]. Przykładowo, zależnie od dziedziny, większość naukowców deklarowała, że przynajmniej raz nie powiodło im się odtworzenie cudzej pracy, w:

- chemii: 90%,

- biologii: 80%,

- fizyce i inżynierii: 70%,

- medycynie: 70%,

- naukach o Ziemi i środowisku: 60%.

W metaanalizie ankiet z 2009 r., ok. 14% badaczy przyznało, że osobiście dopuściło się dowolnych drobnych nadużyć metodologicznych w karierze, a 72% wiedziało, że dopuścił się ich inny znajomy badacz. Do dosłownego fabrykowania danych i wyników przyznało się 2% respondentów[19].

Pod wpływem tych dyskusji, zespoły naukowców z różnych dziedzin psychologii, koordynowane w ramach Open Science Collaboration, przeprowadziły i opublikowały w 2015 r. wyniki powieleń 100 badań psychologicznych opublikowanych w 2008 r. w prestiżowych czasopismach naukowych. Udało się im odtworzyć oryginalne wnioski w 36% przypadków, uzyskując z reguły mniejsze oszacowania wielkości efektu[20]. Grupa ta rekomendowała szereg środków zaradczych w obliczu debatowanego kryzysu, między innymi prerejestrację planów badań, udostępnianie pełnych danych o narzędziach, procedurach i wynikach, dbałość o wystarczającą moc statystyczną, i dalsze, częstsze wykonywanie i publikowanie powieleń[21][22]. Inni autorzy zwrócili uwagę, że powielenia były niedoceniane i publikowane bardzo rzadko (w jednym z przeglądów w psychologii, stanowiły 1% publikacji[23]), w związku z czym proponuje się również systemy premiowania za wykonywanie takich badań[24].

Statystycy, którzy wspólnie z Ronaldem Fisherem stworzyli fundamenty podejścia częstościowego weryfikacji hipotez statystycznych, Neyman i Pearson, zaznaczyli już w 1928 r.: „metody statystyczne powinny być używane z rozwagą i zrozumieniem, a nie jako narzędzia które same w sobie udzielają ostatecznych odpowiedzi[25]”.

Odtwarzalność a moc statystyczna

[edytuj | edytuj kod]

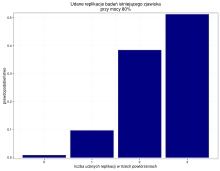

Efektywności odtworzeń i procesu naukowego może przeciwdziałać zaniedbywanie mocy statystycznej badań (w szczególności, stosowanie zbyt małych prób badawczych)[26]. Nawet przy stosowaniu mocy na rekomendowanym poziomie 80%, prawdopodobieństwo że na trzy próby odtworzenia badania, każde się powiedzie, wynosi zaledwie 51%. W praktyce częściej spotykane są jednak niższe wartości mocy testów. W związku z tym, naturalne jest że nawet w przypadku badania rzeczywiście istniejących zjawisk, w literaturze występować będą nieudane odtworzenia. Według statystyków, ocena wartości dowodowej zbioru badań nie powinna w związku z tym polegać na prostym „liczeniu głosów” badań za i przeciwko hipotezie – do wyciągania ogólnych wniosków z wielu badań służą techniki metaanalityczne[27].

Przypisy

[edytuj | edytuj kod]- ↑ https://chem.pg.edu.pl/documents/175289/4236840/6Walidacja%20metodyk%20analitycznych.pdf

- ↑ https://www.umb.edu.pl/photo/pliki/WF_jednostki/zaklad-chemii-nieorganicznej/analityka_(chemia_analityczna)_2019_2020/%28am%29_instrukcja_cwiczenie_7_%28walidacja_wit_c%2B_sumlementy%2Bmocz%29_2019-2020.pdf

- ↑ Metody analiz fermentowanych napojów winiarskich wykonywanych w ramach nadzoru nad jakością handlową tych napojów. - Dz.U.2022.1469 - OpenLEX [online], lex.pl [dostęp 2024-04-24] (pol.).

- ↑ https://eur-lex.europa.eu/legal-content/PL/TXT/PDF/?uri=CELEX:32021R0808&from=FR

- ↑ reproducibility (repeatability, replicability) – odtwarzalność (powtarzalność, zdolność do bycia powielonym) | Pro EBP [online], awf-bp.edu.pl [dostęp 2024-04-24] (pol.).

- ↑ https://link.springer.com/content/pdf/10.1007/s10827-018-0702-z.pdf?pdf=button

- ↑ Barba Lorena A., Terminologies for Reproducible Research, 2018.

- ↑ Liberman Mark, Replicability vs. reproducibility — or is it the other way round? [online] [dostęp 2020-10-15].

- ↑ Karl Popper, Logika odkrycia naukowego, Wydawnictwo Naukowe PWN, 1972, rozdział 4, §22, s. 74, ISBN 83-01-13870-X, OCLC 749339838.

- ↑ Ronald Aylmer Fisher, The design of experiments., Hafner Press, 1974, s. 14, ISBN 978-0-02-844690-5, OCLC 471778573.

- ↑ Mark J. Brandt i inni, The Replication Recipe: What makes for a convincing replication?, „Journal of Experimental Social Psychology”, 50, 2014, s. 217–224, DOI: 10.1016/j.jesp.2013.10.005 [dostęp 2017-01-09].

- ↑ Douglas G. Bonett, Replication-Extension Studies, „Current Directions in Psychological Science”, 6, 2012, s. 409–412, DOI: 10.1177/0963721412459512 [dostęp 2017-01-09] (ang.).

- ↑ Daniël Lakens, Joe Hilgard, Janneke Staaks, On the reproducibility of meta-analyses: six practical recommendations, „BMC Psychology”, 4, 2016, s. 24, DOI: 10.1186/s40359-016-0126-3, ISSN 2050-7283, PMID: 27241618, PMCID: PMC4886411 [dostęp 2017-01-08].

- ↑ Andrew Gelman, Working through some issues, „Significance”, 12 (3), 2015, s. 33–35, DOI: 10.1111/j.1740-9713.2015.00828.x [dostęp 2019-06-26] (ang.).

- ↑ Kay Dickersin i inni, Publication bias and clinical trials, „Controlled Clinical Trials”, 4, 1987, s. 343–353, DOI: 10.1016/0197-2456(87)90155-3 [dostęp 2017-01-08].

- ↑ Mario Biagioli, Watch out for cheats in citation game, „Nature”, 7611, 2016, s. 201–201, DOI: 10.1038/535201a [dostęp 2017-01-08].

- ↑ Joseph P. Simmons, Leif D. Nelson, Uri Simonsohn, False-Positive Psychology: Undisclosed Flexibility in Data Collection and Analysis Allows Presenting Anything as Significant, „Psychological Science”, 11, 2011, s. 1359–1366, DOI: 10.1177/0956797611417632 [dostęp 2017-01-08] (ang.).

- ↑ Monya Baker, 1,500 scientists lift the lid on reproducibility, „Nature”, 7604, 2016, s. 452–454, DOI: 10.1038/533452a [dostęp 2017-01-08].

- ↑ Daniele Fanelli, How Many Scientists Fabricate and Falsify Research? A Systematic Review and Meta-Analysis of Survey Data, „PLOS One”, 5, 2009, e5738, DOI: 10.1371/journal.pone.0005738, ISSN 1932-6203, PMID: 19478950, PMCID: PMC2685008 [dostęp 2017-01-08].

- ↑ Open Science Collaboration, Estimating the reproducibility of psychological science, „Science”, 6251, 2015, aac4716, DOI: 10.1126/science.aac4716, ISSN 0036-8075, PMID: 26315443 [dostęp 2017-01-08] (ang.).

- ↑ Open Science Collaboration, Maximizing the Reproducibility of Your Research, [w:] Scott O. Lilienfeld, Irwin D. Waldman, Psychological Science Under Scrutiny: Recent Challenges and Proposed Solutions, New York: Wiley, 2017, ISBN 978-1-118-66107-9 [dostęp 2017-01-08].

- ↑ Brian A. Nosek i inni, Promoting an open research culture, „Science”, 6242, 2015, s. 1422–1425, DOI: 10.1126/science.aab2374, ISSN 0036-8075, PMID: 26113702, PMCID: PMC4550299 [dostęp 2017-01-08] (ang.).

- ↑ M.C. Makel, J.A. Plucker, B. Hegarty, Replications in Psychology Research: How Often Do They Really Occur?, „Perspectives on Psychological Science”, 6, 2012, s. 537–542, DOI: 10.1177/1745691612460688 [dostęp 2017-01-09] (ang.).

- ↑ Sander L. Koole, Daniel Lakens, Rewarding Replications: A Sure and Simple Way to Improve Psychological Science, „Perspectives on Psychological Science”, 6, 2012, s. 608–614, DOI: 10.1177/1745691612462586 [dostęp 2017-01-08] (ang.).

- ↑ Jerzy Neyman, Egon S. Pearson, On the Use and Interpretation of Certain Test Criteria for Purposes of Statistical Inference: Part I, „Biometrika”, 1/2, 1928, s. 175–240, DOI: 10.2307/2331945, JSTOR: 2331945 [dostęp 2017-01-08].

- ↑ Katherine S. Button i inni, Power failure: why small sample size undermines the reliability of neuroscience, „Nature Reviews Neuroscience”, 5, 2013, s. 365–376, DOI: 10.1038/nrn3475, ISSN 1471-003X [dostęp 2017-01-08] (ang.).

- ↑ Michael Borenstein i inni, Vote Counting – A New Name for an Old Problem, „Introduction to Meta-Analysis”, John Wiley & Sons, Ltd, 2009, s. 251–255, DOI: 10.1002/9780470743386.ch28, ISBN 978-0-470-74338-6 [dostęp 2017-01-08] (ang.).