Odtwarzalność (badania naukowe): Różnice pomiędzy wersjami

początek artykułu |

(Brak różnic)

|

Wersja z 00:27, 9 sty 2017

Replikacja to pojęcie z zakresu metodologii nauk oraz statystyki, opisujące powtarzanie badań w celu zweryfikowania ich wyników, jako część ustawicznego procesu autokorekcyjnego w metodzie naukowej. Słowami filozofa nauki Karla Poppera, „niepowtarzalne, jednostkowe wydarzenia nie mają dla nauki żadnego znaczenia”[1]. Statystyk Ronald Fisher dodaje: „możemy uznać, że zjawisko jest udowodnione eksperymentalnie wówczas, gdy wiemy jak przeprowadzić eksperyment, który rzadko zawiedzie w wykazaniu istotnych statystycznie rezultatów.”[2]

W standardowej procedurze częstościowej weryfikacji hipotez statystycznych, z samej natury konwencjonalnego progu istotności 5% wynika, że 5% wyników przekracza go przez przypadek. W praktyce, idealne założenia modeli statystycznych i metodologii badań nie są dokładnie przestrzegane, z związku z czym liczba „fałszywych alarmów” jest wyższa, niż sugeruje ta nominalna wartość. W związku z tym rola replikacji jest szczególnie istotna.

Kryzys replikacji

Presja instytucjonalna wywierana na badaczy, gdy ocena ich pracy uzależniona jest od arbitralnych kryteriów takich jak istotność statystyczna lub ilości publikacji, zachęca naukowców do nadużywania metod weryfikacji hipotez statystycznych. Obserwuje się, że wskutek niezrozumienia lub celowego naruszania zasad metodologii, badacze i wydawcy czasopism naukowych przywiązywali w praktyce nadmierną wagę do uzyskiwania wyników istotnych statystycznie, niezależnie od tego czy są one prawdziwe, czy nie[3]. Badania które przekroczyły ten próg są publikowane kilkukrotnie częściej[4]. Parafrazując prawo Goodharta, ocena pracy naukowej skupiona na prostych wskaźnikach, takich jak istotność statystyczna, sprawia że zaczynają być one traktowane jak cel sam w sobie, i podważa wiarygodność i rzetelność nauki[5]. Jak udowodnił zespół statystyków, przy pomocy zbioru różnego rodzaju drobnych nadużyć metodologicznych, można uzyskać istotność statystyczną na nominalnym poziomie 5%, przy realnej wartości ponad 50%[6].

W latach 2010-tych opublikowano szereg badań i raportów, sugerujących że zjawisko to ma większą od domniemywanej skalę, i wymaga poważniejszego traktowania. W ankiecie obejmującej ok. 1500 naukowców z różnych dziedzin, 90% respondentów przyznało że nauki są dotknięte kryzysem replikacji, w którym większość wyników nie jest ponownie testowana, a jeśli do tego dochodzi, rezultatów nie udaje się powtórzyć[7]. Przykładowo, zależnie od dziedziny, większość naukowców deklarowała, że przynajmniej raz nie powiodła im się replikacja cudzej pracy, w:

- chemii: 90%,

- biologii: 80%,

- fizyce i inżynierii: 70%,

- medycynie: 70%,

- naukach o Ziemi i środowisku: 60%.

W meta-analizie ankiet z 2009 r., ok. 14% badaczy przyznało, że osobiście dopuściło się dowolnych drobnych nadużyć metodologicznych w karierze, a 72% wie, że dopuścił się ich inny znajomy badacz. Do dosłownego fabrykowania danych i wyników przyznało się 2% respondentów[8].

Pod wpływem tych dyskusji, zespoły naukowców z różnych dziedzin psychologii, koordynowane w ramach Open Science Collaboration, przeprowadziły i opublikowały w 2015 r. wyniki replikacji 100 badań psychologicznych opublikowanych w 2008 r. w prestiżowych czasopismach naukowych. Udało się im powtórzyć oryginalne wnioski w 36% przypadków, uzyskując w większości przypadków mniejsze oszacowania wielkości efektu[9]. Grupa ta rekomenduje szereg środków zaradczych w obliczu debatowanego kryzysu, między innymi prerejestrację planów badań, udostępnianie pełnych danych o narzędziach, procedurach i wynikach, dbałość o wystarczającą moc statystyczną, i dalsze, częstsze wykonywanie i publikowanie replikacji.

Statystycy, którzy wspólnie z Ronaldem Fisherem stworzyli fundamenty podejścia częstościowego weryfikacji hipotez statystycznych, Neyman i Pearson, zaznaczyli już w 1928 r.: „metody statystyczne powinny być używane z rozwagą i zrozumieniem, a nie jako narzędzia które same w sobie udzielają ostatecznych odpowiedzi[10]”.

Replikacja a moc statystyczna

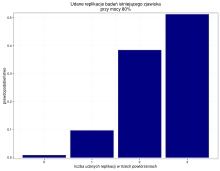

Efektywności replikacji i procesu naukowego może przeciwdziałać zaniedbywanie mocy statystycznej badań (w szczególności, stosowanie zbyt małych prób badawczych). Nawet przy stosowaniu mocy na rekomendowanym poziomie 80%, prawdopodobieństwo że na trzy próby powtórzenia badania, każde się powiedzie, wynosi zaledwie 51%. W praktyce częściej spotykane są jednak niższe wartości mocy testów. W związku z tym, naturalne jest że nawet w przypadku badania rzeczywiście istniejących zjawisk, w literaturze występować będą nieudane replikacje.

Przypisy

- ↑ Karl Popper, Logika odkrycia naukowego, Wydawnictwo Naukowe PWN, 1972, rozdział 4, §22, s. 74, ISBN 83-01-13870-X, OCLC 749339838.

- ↑ R.A. Fisher, The design of experiments., Hafner Press, 1974, s. 14, ISBN 978-0-02-844690-5, OCLC 471778573.

- ↑ Gelman, Andrew. "Statistics and the crisis of scientific replication." Significance 12.3 (2015): 39-41.

- ↑ K. Dickersin i inni, Publication bias and clinical trials, „Controlled Clinical Trials”, 4, 1987, s. 343–353, DOI: 10.1016/0197-2456(87)90155-3 [dostęp 2017-01-08].

- ↑ Mario Biagioli, Watch out for cheats in citation game, „Nature”, 7611, 2016, s. 201–201, DOI: 10.1038/535201a [dostęp 2017-01-08].

- ↑ J.P. Simmons, L.D. Nelson, U. Simonsohn, False-Positive Psychology: Undisclosed Flexibility in Data Collection and Analysis Allows Presenting Anything as Significant, „Psychological Science”, 11, 2011, s. 1359–1366, DOI: 10.1177/0956797611417632 [dostęp 2017-01-08] (ang.).

- ↑ Monya Baker, 1,500 scientists lift the lid on reproducibility, „Nature”, 7604, 2016, s. 452–454, DOI: 10.1038/533452a [dostęp 2017-01-08].

- ↑ Daniele Fanelli, How Many Scientists Fabricate and Falsify Research? A Systematic Review and Meta-Analysis of Survey Data, „PLOS One”, 5, 2009, e5738, DOI: 10.1371/journal.pone.0005738, ISSN 1932-6203, PMID: 19478950, PMCID: PMC2685008 [dostęp 2017-01-08].

- ↑ Open Science Collaboration, Estimating the reproducibility of psychological science, „Science”, 6251, 2015, aac4716, DOI: 10.1126/science.aac4716, ISSN 0036-8075, PMID: 26315443 [dostęp 2017-01-08] (ang.).

- ↑ J. Neyman, E.S. Pearson, On the Use and Interpretation of Certain Test Criteria for Purposes of Statistical Inference: Part I, „Biometrika”, 1/2, 1928, s. 175–240, DOI: 10.2307/2331945, JSTOR: 2331945 [dostęp 2017-01-08].