Wnioskowanie częstościowe: Różnice pomiędzy wersjami

| [wersja nieprzejrzana] | [wersja nieprzejrzana] |

utworzenie artykułu |

dalsze rozwinięcie +źródła |

||

| Linia 26: | Linia 26: | ||

|- |

|- |

||

|} |

|} |

||

Modele statystyczne używane w podejściu częstościowym mają dobrze znane właściwości, w związku z czym można określić, jak często przez naturalną [[Miara zróżnicowania rozkładu|zmienność]] [[Próba statystyczna|prób statystycznych]] ([[błąd przypadkowy]]) możemy spodziewać się obserwacji przypadkowo wprowadzających badacza w błąd. W [[Prawdopodobieństwo obiektywne|częstościowej interpretacji prawdopodobieństwa]] wynik każdego eksperymentu rozpatruje się jako jeden z nieskończonej liczby losowych, potencjalnych pomiarów nieznanych stałych wartości. Ponieważ znane są właściwości statystyczne modelu, można obliczyć <math>\Pr(D|H)</math> – prawdopodobieństwo uzyskania obserwacji danych '''''D''''', przy założeniu hipotezy '''''H'''''. Jeśli prawdopodobieństwo to (tzw. [[P-wartość]]) jest mniejsze od przyjętej przez badacza [[Wartość krytyczna|wartości krytycznej]], może przyjąć że dane są przesłanką na rzecz falsyfikacji hipotezy '''''H''''', i nie pomyli się czyniąc tak częściej niż wyznacza wybrana wartość krytyczna. Należy zwrócić jednak uwagę, że – kontrintuicyjnie – w podejściu częstościowym nie mówi się o odwrotnym, często bardziej interesującym badaczy prawdopodobieństwie: <math>\Pr(H|D)</math>, a więc pewności jaką można przypisać badanej hipotezie. Wartość ta koreluje jedynie słabo, zależnie od |

Modele statystyczne używane w podejściu częstościowym mają dobrze znane właściwości, w związku z czym można określić, jak często przez naturalną [[Miara zróżnicowania rozkładu|zmienność]] [[Próba statystyczna|prób statystycznych]] ([[błąd przypadkowy]]) możemy spodziewać się obserwacji przypadkowo wprowadzających badacza w błąd. W [[Prawdopodobieństwo obiektywne|częstościowej interpretacji prawdopodobieństwa]] wynik każdego eksperymentu rozpatruje się jako jeden z nieskończonej liczby losowych, potencjalnych pomiarów nieznanych stałych wartości. Ponieważ znane są właściwości statystyczne modelu, można obliczyć <math>\Pr(D|H)</math> – prawdopodobieństwo uzyskania obserwacji danych '''''D''''', przy założeniu hipotezy '''''H'''''. Jeśli prawdopodobieństwo to (tzw. [[P-wartość]]) jest mniejsze od przyjętej przez badacza [[Wartość krytyczna|wartości krytycznej]], może przyjąć że dane są przesłanką na rzecz falsyfikacji hipotezy '''''H''''', i nie pomyli się czyniąc tak częściej niż wyznacza wybrana wartość krytyczna. Należy zwrócić jednak uwagę, że – kontrintuicyjnie – w podejściu częstościowym nie mówi się o odwrotnym, często bardziej interesującym badaczy prawdopodobieństwie: <math>\Pr(H|D)</math>, a więc pewności jaką można przypisać badanej hipotezie. Wartość ta koreluje jedynie słabo, zależnie od mocy i poziomu istotności użytego testu, z <math>\Pr(D|H)</math><ref name=":1">{{Cytuj|autor=David Trafimow, Stephen Rice|tytuł=A test of the null hypothesis significance testing procedure correlation argument|czasopismo=The Journal of General Psychology|data=2009-07-01|data dostępu=2017-01-15|issn=0022-1309|wolumin=136|numer=3|s=261–269|doi=10.3200/GENP.136.3.261-270|pmid=19650521|url=https://www.ncbi.nlm.nih.gov/pubmed/19650521}}</ref>. Podejście częstościowe zapewnia więc konkretny poziom pewności co do decyzji, ale nie daje bezpośrednio wiedzy co do prawdopodobieństwa hipotez. Wynika to z fundamentalnych założeń filozoficznych twórców tej metody – Fisher, i zwłaszcza Neyman, uważali że mówienie o prawdopodobieństwie hipotez jest błędem logicznym, ponieważ hipoteza może być jedynie albo prawdziwa, albo fałszywa. W opozycji do tego poglądu, [[wnioskowanie bayesowskie]] opiera się na pojęciu [[Prawdopodobieństwo subiektywne|prawdopodobieństwa subiektywnego]], a wynik każdego eksperymentu traktuje jako stałe dane, reprezentujące w modelu nieznane zmienne losowe<ref>{{Cytuj|autor=E. T. Jaynes, G. Larry Bretthorst|tytuł=Probability Theory: The Logic of Science|data=2003-04-10|data dostępu=2017-01-14|isbn=9780521592710|wydawca=Cambridge University Press|url=https://books.google.pl/books/about/Probability_Theory.html?id=tTN4HuUNXjgC&redir_esc=y|język=en}}</ref>. |

||

| ⚫ | |||

== Hipoteza zerowa i hipoteza alternatywna == |

|||

| ⚫ | Wnioskowanie częstościowe jest amalgamatem modeli stworzonych przez Fishera oraz Neymana i Pearsona<ref name=":0" />. Ronald Fisher zaproponował w 1925 r., aby [[weryfikacja hipotez statystycznych]] polegała na teście istotności – obliczaniu [[P-wartość|P-wartości]] danych (prawdopodobieństwa uzyskania takich, lub bardziej ekstremalnych obserwacji) przy założeniu [[Hipoteza zerowa|hipotezy zerowej]]: braku jakichkolwiek różnic. Napisał również, że P-wartość jest wyrazem wartości dowodowej danych przeciwko hipotezie zerowej. Zaproponował przyjęcie [[Wartość krytyczna|krytycznej wartości]] na poziomie 5% jako luźnej konwencji, która może być dostosowywana do konkretnego obszaru badawczego<ref>{{Cytuj|autor=Fisher, Ronald Aylmer, Sir, 1890-1962.|tytuł=Statistical methods for research workers.|data=1970-01-01|isbn=0050021702|wydawca=Oliver and Boyd}}</ref>. Neyman i Pearson odrzucili taką interpretację m.in. w pracy z 1933 r., krytykując subiektywną naturę sądów o prawdziwości hipotez (z którą to obiekcją Fisher się zgadzał), i zaproponowali sformułowanie procesu weryfikacji hipotez statystycznych jako testu hipotez, w języku teorii decyzji: jakie należy przyjąć zasady postępowania, aby w długim horyzoncie czasowym nie popełniać błędów częściej niż przyjęto<ref>{{Cytuj|autor=J. Neyman, E. S. Pearson|tytuł=On the Problem of the Most Efficient Tests of Statistical Hypotheses|czasopismo=Philosophical Transactions of the Royal Society of London A: Mathematical, Physical and Engineering Sciences|data=1933-01-01|data dostępu=2017-01-14|issn=1364-503X|wolumin=231|numer=694-706|s=289–337|doi=10.1098/rsta.1933.0009|url=http://rsta.royalsocietypublishing.org/content/231/694-706/289|język=en}}</ref>. Rozróżnili dwie hipotezy: [[Hipoteza zerowa|zerową]] i [[Hipoteza alternatywna|alternatywną]], oraz ryzyko popełnienia [[Błąd pierwszego rodzaju|błędu pierwszego]] i [[Błąd drugiego rodzaju|drugiego rodzaju]] (odpowiednio, błędnym przyjęciu hipotezy zerowej i alternatywnej). W ich ujęciu, testowanie hipotez polega na zero-jedynkowym podejmowaniu decyzji co do wyboru jednej lub drugiej hipotezy, przy kontroli częstości podejmowania błędów, i z użyciem testu statystycznego wybranego według kryterium najwyższej [[Moc testu|mocy statystycznej]] w danym zastosowaniu. Neyman i Pearson odrzucili możliwość bezpośredniego rozważania P-wartości zaobserwowanych danych jako ich wartości dowodowej, i podkreślali, że procedura wymaga przyjęcia ''a priori'' dopuszczalnego poziomu obu błędów, a parametry danych ''a posteriori'' nie powinny być poza tym traktowane jako informatywne. Spór statystyków pozostał niepogodzony do końca ich życia<ref name=":2">{{Cytuj|autor=Raymond Hubbard, M. J. Bayarri, Kenneth N. Berk, Matthew A. Carlton|tytuł=Confusion over Measures of Evidence (p's) versus Errors (α's) in Classical Statistical Testing|czasopismo=The American Statistician|data=2003-01-01|data dostępu=2017-01-15|wolumin=57|numer=3|s=171–182|url=http://www.jstor.org/stable/30037265}}</ref>. |

||

| ⚫ | Po 1940 r. oba podejścia zaczęły być, wbrew woli twórców, łączone w podręcznikach w hybrydową postać, i przedstawiane przy pomocy języka sugerującego, że mogą być używane do wyciągania bayesowskich wniosków o prawdopodobieństwie hipotez<ref>{{Cytuj|autor=Gideon Keren, Charles Lewis|autor r=Gerd Gigerenzer|rozdział=The superego, the ego, and the id in statistical reasoning|tytuł=A Handbook for Data Analysis in the Behaviorial Sciences: Volume 1: Methodological Issues Volume 2: Statistical Issues|data=2014-01-14|data dostępu=2017-01-15|isbn=9781317759980|wydawca=Psychology Press|url=https://books.google.pl/books?hl=pl&lr=&id=fTyYAgAAQBAJ|język=en}}</ref>. Sprawia to, że podejście częstościowe wiąże się z wieloma nieintuicyjnymi problemami interpretacyjnymi<ref name=":0" /><ref name=":2" />. |

||

| ⚫ | |||

| ⚫ | Wnioskowanie częstościowe jest amalgamatem modeli stworzonych przez Fishera oraz Neymana i Pearsona<ref name=":0" />. Ronald Fisher zaproponował w 1925 r., aby [[weryfikacja hipotez statystycznych]] polegała na teście istotności – obliczaniu [[P-wartość|P-wartości]] danych (prawdopodobieństwa uzyskania takich, lub bardziej ekstremalnych obserwacji) przy założeniu [[Hipoteza zerowa|hipotezy zerowej]]: braku jakichkolwiek różnic. Napisał również, że P-wartość jest wyrazem wartości dowodowej danych przeciwko hipotezie zerowej. Zaproponował przyjęcie [[Wartość krytyczna|krytycznej wartości]] na poziomie 5% jako luźnej konwencji, która może być dostosowywana do konkretnego obszaru badawczego<ref>{{Cytuj|autor=Fisher, Ronald Aylmer, Sir, 1890-1962.|tytuł=Statistical methods for research workers.|data=1970-01-01|isbn=0050021702|wydawca=Oliver and Boyd}}</ref>. Neyman i Pearson odrzucili taką interpretację m.in. w pracy z 1933 r., krytykując subiektywną naturę sądów o prawdziwości hipotez (z którą to obiekcją Fisher się zgadzał), i zaproponowali sformułowanie procesu weryfikacji hipotez statystycznych jako testu hipotez, w języku teorii decyzji: jakie należy przyjąć zasady postępowania, aby w długim horyzoncie czasowym nie popełniać błędów częściej niż przyjęto<ref>{{Cytuj|autor=J. Neyman, E. S. Pearson|tytuł=On the Problem of the Most Efficient Tests of Statistical Hypotheses|czasopismo=Philosophical Transactions of the Royal Society of London A: Mathematical, Physical and Engineering Sciences|data=1933-01-01|data dostępu=2017-01-14|issn=1364-503X|wolumin=231|numer=694-706|s=289–337|doi=10.1098/rsta.1933.0009|url=http://rsta.royalsocietypublishing.org/content/231/694-706/289|język=en}}</ref>. Rozróżnili dwie hipotezy: [[Hipoteza zerowa|zerową]] i [[Hipoteza alternatywna|alternatywną]], oraz ryzyko popełnienia [[Błąd pierwszego rodzaju|błędu pierwszego]] i [[Błąd drugiego rodzaju|drugiego rodzaju]] (odpowiednio, błędnym przyjęciu hipotezy zerowej i alternatywnej). W ich ujęciu, testowanie hipotez polega na zero-jedynkowym podejmowaniu decyzji co do wyboru jednej lub drugiej hipotezy, przy kontroli częstości podejmowania błędów, i z użyciem testu statystycznego wybranego według kryterium najwyższej [[Moc testu|mocy statystycznej]] w danym zastosowaniu. Neyman i Pearson odrzucili możliwość bezpośredniego rozważania P-wartości zaobserwowanych danych jako ich wartości dowodowej, i podkreślali, że procedura wymaga przyjęcia ''a priori'' dopuszczalnego poziomu obu błędów, a parametry danych ''a posteriori'' nie powinny być poza tym traktowane jako informatywne. Spór statystyków pozostał niepogodzony do końca ich życia. |

||

| ⚫ | Po 1940 r. oba podejścia zaczęły być, wbrew woli twórców, łączone w podręcznikach w hybrydową postać, i przedstawiane przy pomocy języka sugerującego, że mogą być używane do wyciągania bayesowskich wniosków o prawdopodobieństwie hipotez<ref>{{Cytuj|autor=Gideon Keren, Charles Lewis|autor r=Gerd Gigerenzer|rozdział=The superego, the ego, and the id in statistical reasoning|tytuł=A Handbook for Data Analysis in the Behaviorial Sciences: Volume 1: Methodological Issues Volume 2: Statistical Issues|data=2014-01-14|data dostępu=2017-01-15|isbn=9781317759980|wydawca=Psychology Press|url=https://books.google.pl/books?hl=pl&lr=&id=fTyYAgAAQBAJ|język=en}}</ref>. Sprawia to, że podejście częstościowe wiąże się z wieloma nieintuicyjnymi problemami interpretacyjnymi<ref name=":0" />. |

||

== Prawidłowa realizacja badań i interpretacja wyników == |

== Prawidłowa realizacja badań i interpretacja wyników == |

||

| Linia 39: | Linia 37: | ||

=== Realizacja badania === |

=== Realizacja badania === |

||

W modelu Neymana/Pearsona, częstościowa procedura weryfikacji hipotez statystycznych ma sens tylko wtedy, jeśli badacz |

W modelu Neymana/Pearsona, częstościowa procedura weryfikacji hipotez statystycznych ma sens tylko wtedy, jeśli badacz postępuje według z góry ustalonego planu badawczego. Badacz który testuje hipotezy powinien przedstawić wyniki wszystkich zaplanowanych porównań, i ani nie pomijać, ani nie uwzględniać żadnych dodatkowych testów. Badania metodologiczne potwierdzają, że tego typu decyzje co do analizy danych ''ad hoc'', po ich zebraniu, sprawiają że nominalne ryzyko błędów w rzeczywistości bardzo wzrasta. Błędy tego typu obejmują m.in. zjawiska nazywane [[P-hacking|P-hackingiem]] oraz [[HARKing|HARKingiem]] (od ang. ''hypothesizing after the results are known'' – stawianie hipotez po poznaniu danych)<ref>{{Cytuj|autor=J. P. Simmons, L. D. Nelson, U. Simonsohn|tytuł=False-Positive Psychology: Undisclosed Flexibility in Data Collection and Analysis Allows Presenting Anything as Significant|czasopismo=Psychological Science|data=2011-10-17|data dostępu=2017-01-15|wolumin=22|numer=11|s=1359–1366|doi=10.1177/0956797611417632|url=http://journals.sagepub.com/doi/abs/10.1177/0956797611417632|język=en}}</ref><ref>{{Cytuj|autor=N. L. Kerr|tytuł=HARKing: hypothesizing after the results are known|czasopismo=Personality and Social Psychology Review: An Official Journal of the Society for Personality and Social Psychology, Inc|data=1998-01-01|data dostępu=2017-01-15|issn=1088-8683|wolumin=2|numer=3|s=196–217|doi=10.1207/s15327957pspr0203_4|pmid=15647155|url=https://www.ncbi.nlm.nih.gov/pubmed/15647155}}</ref>. Dopuszczalne są badania, które służą eksploracji danych ([[badania eksploracyjne]]), a nie testowaniu hipotez ([[badania konfirmacyjne]]), ale nieuprawnione jest przedstawianie jednych jako drugich. Wyniki przeglądów publikacji sugerują, że takie błędy metodologiczne mogą być w naukach powszechne<ref>{{Cytuj|autor=Megan L. Head, Luke Holman, Rob Lanfear, Andrew T. Kahn, Michael D. Jennions|tytuł=The Extent and Consequences of P-Hacking in Science|czasopismo=PLOS Biology|data=2015-03-13|data dostępu=2017-01-15|issn=1545-7885|wolumin=13|numer=3|s=e1002106|doi=10.1371/journal.pbio.1002106|pmid=25768323|pmc=4359000|url=http://journals.plos.org/plosbiology/article?id=10.1371/journal.pbio.1002106}}</ref><ref>{{Cytuj|autor=Daniele Fanelli|tytuł=“Positive” Results Increase Down the Hierarchy of the Sciences|czasopismo=PLOS ONE|data=2010-04-07|data dostępu=2017-01-15|issn=1932-6203|wolumin=5|numer=4|s=e10068|doi=10.1371/journal.pone.0010068|pmid=20383332|pmc=2850928|url=http://journals.plos.org/plosone/article?id=10.1371/journal.pone.0010068}}</ref>. |

||

=== Interpretacja wyniku istotnego statystycznie === |

=== Interpretacja wyniku istotnego statystycznie === |

||

[[Plik:Rozkład wartości p dla H0 i H1 przy wysokiej mocy testu.svg|alt=Rozkład P-wartości dla hipotezy zerowej i alternatywnej przy wysokiej mocy statystycznej. Wartości p niewiele mniejsze od 0,05 mogą być w tym przypadku nieintuicyjnie bardziej prawdopodobne w hipotezie zerowej, choć procedura każe ją odrzucić.|mały|Rozkład P-wartości dla hipotezy zerowej i alternatywnej przy wysokiej mocy statystycznej. Wartości p niewiele mniejsze od 0,05 mogą być w tym przypadku nieintuicyjnie bardziej prawdopodobne w hipotezie zerowej, choć procedura każe ją odrzucić.]] |

[[Plik:Rozkład wartości p dla H0 i H1 przy wysokiej mocy testu.svg|alt=Rozkład P-wartości dla hipotezy zerowej i alternatywnej przy wysokiej mocy statystycznej. Wartości p niewiele mniejsze od 0,05 mogą być w tym przypadku nieintuicyjnie bardziej prawdopodobne w hipotezie zerowej, choć procedura każe ją odrzucić.|mały|Rozkład P-wartości dla hipotezy zerowej i alternatywnej przy wysokiej mocy statystycznej. Wartości p niewiele mniejsze od 0,05 mogą być w tym przypadku nieintuicyjnie bardziej prawdopodobne w hipotezie zerowej, choć procedura każe ją odrzucić.]] |

||

Wynik istotny statystycznie uprawnia do przyjęcia, że można postępować tak, jakby hipoteza alternatywna była prawdziwa. Działając w zgodzie z tą zasadą nie popełnimy błędów częściej niż stanowi przyjęta przez nas nominalna wartość krytyczna. Nie daje |

Wynik istotny statystycznie uprawnia do przyjęcia, że można postępować tak, jakby hipoteza alternatywna była prawdziwa. Działając w zgodzie z tą zasadą nie popełnimy błędów częściej niż stanowi przyjęta przez nas nominalna wartość krytyczna. Nie daje jednak bezpośrednio informacji o tym, czy hipoteza ta jest prawdziwa, ponieważ jest to odwrotne prawdopodobieństwo warunkowe: <math>\Pr(D|H) \neq \Pr(H|D)</math>, które to wartości w praktyce jedynie słabo ze sobą korelują (r≈0,37 w symulacjach zakładających hipotezę zerową i losowy poziom mocy)<ref name=":1" />. Testowana jest ponadto z reguły hipoteza zerowa – jej odrzucenie nie oznacza, że prawdopodobna jest konkretna hipoteza alternatywna. O prawdopodobieństwie konkretnej hipotezy pozwalają mówić [[Wnioskowanie bayesowskie|metody bayesowskie]] lub ilorazy wiarygodności. |

||

Poziom P-wartości obliczony ''a posteriori'' w oparciu o zaobserwowane dane nie wyraża tego, jakim ryzykiem popełnienia błędu pierwszego rodzaju są obarczone – wynosi on zawsze tyle, jaką [[Wartość krytyczna|wartość krytyczną]] ([[poziom istotności]]) przyjęto ''a priori'' – z reguły, α=0,05<ref name=":2" />. |

|||

Rozkład P-wartości przy założeniu hipotezy zerowej jest jednostajny – każdy wynik jest jednakowo prawdopodobny. W przypadku hipotezy alternatywnej, przy wysokiej [[Moc testu|mocy statystycznej]] badania, oczekiwany rozkład P-wartości jest mocno prawoskośny. Prowadzi to do sytuacji, w których przy wysokiej mocy pewne wartości ''p'', choć znajdują się poniżej wartości krytycznej, są jednak bardziej typowe dla hipotezy zerowej<ref>{{Cytuj|autor=Daniël Lakens|tytuł=On the challenges of drawing conclusions fromp-values just below 0.05|czasopismo=PeerJ|data=2015-07-30|data dostępu=2017-01-15|issn=2167-8359|wolumin=3|doi=10.7717/peerj.1142|pmid=26246976|pmc=4525697|url=https://peerj.com/articles/1142/|język=en}}</ref>. |

Rozkład P-wartości przy założeniu hipotezy zerowej jest jednostajny – każdy wynik jest jednakowo prawdopodobny. W przypadku hipotezy alternatywnej, przy wysokiej [[Moc testu|mocy statystycznej]] badania, oczekiwany rozkład P-wartości jest mocno prawoskośny. Prowadzi to do sytuacji, w których przy wysokiej mocy pewne wartości ''p'', choć znajdują się poniżej wartości krytycznej, są jednak bardziej typowe dla hipotezy zerowej<ref>{{Cytuj|autor=Daniël Lakens|tytuł=On the challenges of drawing conclusions fromp-values just below 0.05|czasopismo=PeerJ|data=2015-07-30|data dostępu=2017-01-15|issn=2167-8359|wolumin=3|doi=10.7717/peerj.1142|pmid=26246976|pmc=4525697|url=https://peerj.com/articles/1142/|język=en}}</ref>. |

||

Wysoka [[Moc testu|moc statystyczna]] badania powoduje, że nawet mikroskopijne różnice w obserwacjach zaowocują osiągnięciem przez test istotności statystycznej. Istotność statystyczna nie świadczy bezpośrednio o wartości dowodowej danych, ani o istotności praktycznej badanego zjawiska. Praktyczną istotność należy rozważać rozpatrując [[wielkość efektu]] wraz z jej [[Przedział ufności|przedziałem ufności]]. Stosowanie tych miar jest obecnie rekomendowane np. przez [[Amerykańskie Towarzystwo Psychologiczne]]<ref>{{Cytuj|autor=Wilkinson, Leland, Task Force on Statistical Inference, American Psychological Association, Science Directorate, Washington DC US|tytuł=Statistical methods in psychology journals: Guidelines and explanations.|czasopismo=American Psychologist|data=1999-08-01|data dostępu=2017-01-15|issn=1935-990X|wolumin=54|numer=8|doi=10.1037/0003-066X.54.8.594|url=http://psycnet.apa.org/journals/amp/54/8/594/}}</ref>. |

Wysoka [[Moc testu|moc statystyczna]] badania powoduje, że nawet mikroskopijne różnice w obserwacjach zaowocują osiągnięciem przez test istotności statystycznej. Istotność statystyczna nie świadczy bezpośrednio o wartości dowodowej danych, ani o istotności praktycznej badanego zjawiska. Praktyczną istotność należy rozważać rozpatrując [[wielkość efektu]] wraz z jej [[Przedział ufności|przedziałem ufności]]<ref>{{Cytuj|autor=Jacob Cohen|tytuł=The earth is round (p < .05): Rejoinder.|czasopismo=American Psychologist|data dostępu=2017-01-15|wolumin=50|numer=12|s=1103–1103|doi=10.1037/0003-066x.50.12.1103|url=http://dx.doi.org/10.1037/0003-066X.50.12.1103}}</ref>. Stosowanie tych miar jest obecnie rekomendowane np. przez [[Amerykańskie Towarzystwo Psychologiczne]]<ref>{{Cytuj|autor=Wilkinson, Leland, Task Force on Statistical Inference, American Psychological Association, Science Directorate, Washington DC US|tytuł=Statistical methods in psychology journals: Guidelines and explanations.|czasopismo=American Psychologist|data=1999-08-01|data dostępu=2017-01-15|issn=1935-990X|wolumin=54|numer=8|doi=10.1037/0003-066X.54.8.594|url=http://psycnet.apa.org/journals/amp/54/8/594/}}</ref>. |

||

=== Interpretacja wyniku nieistotnego statystycznie === |

=== Interpretacja wyniku nieistotnego statystycznie === |

||

Wersja z 05:44, 15 sty 2017

Wnioskowanie częstościowe (ang. frequentist inference), NHST, (ang. null hypothesis significance testing), statystyka częstościowa – podejście w dziedzinie wnioskowania statystycznego oparte na falsyfikacji hipotez statystycznych w oparciu o ich oczekiwane długoterminowe właściwości. Jest ono amalgamatem metod wypracowanych przez Ronalda Fishera oraz Neymana i Pearsona[1]. Jego główną właściwością jest to, że w długim horyzoncie czasowym, badacz posługujący się prawidłowo metodami częstościowymi nie popełni błędów decyzyjnych statystycznie częściej, niż założył. Charakterystycznym dla statystyki częstościowej narzędziem jest P-wartość testu. Głównymi alternatywnymi podejściami jest wnioskowanie bayesowskie i stosowanie ilorazów wiarygodności.

Wnioskowanie statystyczne wyróżnia dwa rodzaje błędów decyzyjnych i dwa rodzaje prawidłowych decyzji, co ilustruje następująca tablica pomyłek:

| |||||||||||||

Modele statystyczne używane w podejściu częstościowym mają dobrze znane właściwości, w związku z czym można określić, jak często przez naturalną zmienność prób statystycznych (błąd przypadkowy) możemy spodziewać się obserwacji przypadkowo wprowadzających badacza w błąd. W częstościowej interpretacji prawdopodobieństwa wynik każdego eksperymentu rozpatruje się jako jeden z nieskończonej liczby losowych, potencjalnych pomiarów nieznanych stałych wartości. Ponieważ znane są właściwości statystyczne modelu, można obliczyć – prawdopodobieństwo uzyskania obserwacji danych D, przy założeniu hipotezy H. Jeśli prawdopodobieństwo to (tzw. P-wartość) jest mniejsze od przyjętej przez badacza wartości krytycznej, może przyjąć że dane są przesłanką na rzecz falsyfikacji hipotezy H, i nie pomyli się czyniąc tak częściej niż wyznacza wybrana wartość krytyczna. Należy zwrócić jednak uwagę, że – kontrintuicyjnie – w podejściu częstościowym nie mówi się o odwrotnym, często bardziej interesującym badaczy prawdopodobieństwie: , a więc pewności jaką można przypisać badanej hipotezie. Wartość ta koreluje jedynie słabo, zależnie od mocy i poziomu istotności użytego testu, z [2]. Podejście częstościowe zapewnia więc konkretny poziom pewności co do decyzji, ale nie daje bezpośrednio wiedzy co do prawdopodobieństwa hipotez. Wynika to z fundamentalnych założeń filozoficznych twórców tej metody – Fisher, i zwłaszcza Neyman, uważali że mówienie o prawdopodobieństwie hipotez jest błędem logicznym, ponieważ hipoteza może być jedynie albo prawdziwa, albo fałszywa. W opozycji do tego poglądu, wnioskowanie bayesowskie opiera się na pojęciu prawdopodobieństwa subiektywnego, a wynik każdego eksperymentu traktuje jako stałe dane, reprezentujące w modelu nieznane zmienne losowe[3].

Tło historyczne

Wnioskowanie częstościowe jest amalgamatem modeli stworzonych przez Fishera oraz Neymana i Pearsona[1]. Ronald Fisher zaproponował w 1925 r., aby weryfikacja hipotez statystycznych polegała na teście istotności – obliczaniu P-wartości danych (prawdopodobieństwa uzyskania takich, lub bardziej ekstremalnych obserwacji) przy założeniu hipotezy zerowej: braku jakichkolwiek różnic. Napisał również, że P-wartość jest wyrazem wartości dowodowej danych przeciwko hipotezie zerowej. Zaproponował przyjęcie krytycznej wartości na poziomie 5% jako luźnej konwencji, która może być dostosowywana do konkretnego obszaru badawczego[4]. Neyman i Pearson odrzucili taką interpretację m.in. w pracy z 1933 r., krytykując subiektywną naturę sądów o prawdziwości hipotez (z którą to obiekcją Fisher się zgadzał), i zaproponowali sformułowanie procesu weryfikacji hipotez statystycznych jako testu hipotez, w języku teorii decyzji: jakie należy przyjąć zasady postępowania, aby w długim horyzoncie czasowym nie popełniać błędów częściej niż przyjęto[5]. Rozróżnili dwie hipotezy: zerową i alternatywną, oraz ryzyko popełnienia błędu pierwszego i drugiego rodzaju (odpowiednio, błędnym przyjęciu hipotezy zerowej i alternatywnej). W ich ujęciu, testowanie hipotez polega na zero-jedynkowym podejmowaniu decyzji co do wyboru jednej lub drugiej hipotezy, przy kontroli częstości podejmowania błędów, i z użyciem testu statystycznego wybranego według kryterium najwyższej mocy statystycznej w danym zastosowaniu. Neyman i Pearson odrzucili możliwość bezpośredniego rozważania P-wartości zaobserwowanych danych jako ich wartości dowodowej, i podkreślali, że procedura wymaga przyjęcia a priori dopuszczalnego poziomu obu błędów, a parametry danych a posteriori nie powinny być poza tym traktowane jako informatywne. Spór statystyków pozostał niepogodzony do końca ich życia[6].

Po 1940 r. oba podejścia zaczęły być, wbrew woli twórców, łączone w podręcznikach w hybrydową postać, i przedstawiane przy pomocy języka sugerującego, że mogą być używane do wyciągania bayesowskich wniosków o prawdopodobieństwie hipotez[7]. Sprawia to, że podejście częstościowe wiąże się z wieloma nieintuicyjnymi problemami interpretacyjnymi[1][6].

Prawidłowa realizacja badań i interpretacja wyników

Realizacja badania

W modelu Neymana/Pearsona, częstościowa procedura weryfikacji hipotez statystycznych ma sens tylko wtedy, jeśli badacz postępuje według z góry ustalonego planu badawczego. Badacz który testuje hipotezy powinien przedstawić wyniki wszystkich zaplanowanych porównań, i ani nie pomijać, ani nie uwzględniać żadnych dodatkowych testów. Badania metodologiczne potwierdzają, że tego typu decyzje co do analizy danych ad hoc, po ich zebraniu, sprawiają że nominalne ryzyko błędów w rzeczywistości bardzo wzrasta. Błędy tego typu obejmują m.in. zjawiska nazywane P-hackingiem oraz HARKingiem (od ang. hypothesizing after the results are known – stawianie hipotez po poznaniu danych)[8][9]. Dopuszczalne są badania, które służą eksploracji danych (badania eksploracyjne), a nie testowaniu hipotez (badania konfirmacyjne), ale nieuprawnione jest przedstawianie jednych jako drugich. Wyniki przeglądów publikacji sugerują, że takie błędy metodologiczne mogą być w naukach powszechne[10][11].

Interpretacja wyniku istotnego statystycznie

Wynik istotny statystycznie uprawnia do przyjęcia, że można postępować tak, jakby hipoteza alternatywna była prawdziwa. Działając w zgodzie z tą zasadą nie popełnimy błędów częściej niż stanowi przyjęta przez nas nominalna wartość krytyczna. Nie daje jednak bezpośrednio informacji o tym, czy hipoteza ta jest prawdziwa, ponieważ jest to odwrotne prawdopodobieństwo warunkowe: , które to wartości w praktyce jedynie słabo ze sobą korelują (r≈0,37 w symulacjach zakładających hipotezę zerową i losowy poziom mocy)[2]. Testowana jest ponadto z reguły hipoteza zerowa – jej odrzucenie nie oznacza, że prawdopodobna jest konkretna hipoteza alternatywna. O prawdopodobieństwie konkretnej hipotezy pozwalają mówić metody bayesowskie lub ilorazy wiarygodności.

Poziom P-wartości obliczony a posteriori w oparciu o zaobserwowane dane nie wyraża tego, jakim ryzykiem popełnienia błędu pierwszego rodzaju są obarczone – wynosi on zawsze tyle, jaką wartość krytyczną (poziom istotności) przyjęto a priori – z reguły, α=0,05[6].

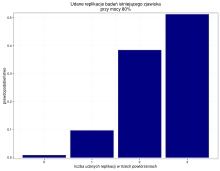

Rozkład P-wartości przy założeniu hipotezy zerowej jest jednostajny – każdy wynik jest jednakowo prawdopodobny. W przypadku hipotezy alternatywnej, przy wysokiej mocy statystycznej badania, oczekiwany rozkład P-wartości jest mocno prawoskośny. Prowadzi to do sytuacji, w których przy wysokiej mocy pewne wartości p, choć znajdują się poniżej wartości krytycznej, są jednak bardziej typowe dla hipotezy zerowej[12].

Wysoka moc statystyczna badania powoduje, że nawet mikroskopijne różnice w obserwacjach zaowocują osiągnięciem przez test istotności statystycznej. Istotność statystyczna nie świadczy bezpośrednio o wartości dowodowej danych, ani o istotności praktycznej badanego zjawiska. Praktyczną istotność należy rozważać rozpatrując wielkość efektu wraz z jej przedziałem ufności[13]. Stosowanie tych miar jest obecnie rekomendowane np. przez Amerykańskie Towarzystwo Psychologiczne[14].

Interpretacja wyniku nieistotnego statystycznie

Wynik nieistotny jest nieinformatywny – nie świadczy ani na rzecz, ani przeciwko hipotezie zerowej. Uprawnia do postępowania tak, jakby była prawdziwa. W celu rozstrzygnięcia jej prawdziwości, można zastosować iloraz wiarygodności lub metody wnioskowana bayesowskiego. Jeśli badacz po uzyskaniu wyniku nieistotnego nadal uważa, że jego hipoteza alternatywna jest prawdziwa, może rozważyć wykonanie replikacji badania z wyższą mocą statystyczną.

Replikacje i metaanalizy

Kluczowa dla metody naukowej jest ograniczona wiarygodność pojedynczych zbiorów obserwacji. Dopiero badanie, które niezależnie zreplikowano, pozwala mówić o jakiejś wiedzy. Statystyk Ronald Fisher stwierdza: „możemy uznać, że zjawisko jest udowodnione eksperymentalnie wówczas, gdy wiemy, jak przeprowadzić eksperyment, który rzadko zawiedzie w wykazaniu istotnych statystycznie rezultatów.”[15] Nieudane replikacje nie świadczą przy tym koniecznie o nieprawdziwości hipotezy, ponieważ nawet przy wysokiej mocy statystycznej i badaniu prawdziwego zjawiska można oczekiwać, że wystąpią przypadkowe nieistotne powtórzenia testów. Właściwą metodą, która służy rzetelnemu agregowaniu wyników wielu badań i wyciąganiu z nich wniosków jest metaanaliza[16]. Neyman i Pearson zaznaczyli ponadto już w 1928 r.: „metody statystyczne powinny być używane z rozwagą i zrozumieniem, a nie jako narzędzia które same w sobie udzielają ostatecznych odpowiedzi”[17].

- ↑ a b c Jesper W. Schneider, Null hypothesis significance tests. A mix-up of two different theories: the basis for widespread confusion and numerous misinterpretations, „Scientometrics”, 102 (1), 2014, s. 411–432, DOI: 10.1007/s11192-014-1251-5, ISSN 0138-9130 [dostęp 2017-01-14] (ang.).

- ↑ a b David Trafimow, Stephen Rice, A test of the null hypothesis significance testing procedure correlation argument, „The Journal of General Psychology”, 136 (3), 2009, s. 261–269, DOI: 10.3200/GENP.136.3.261-270, ISSN 0022-1309, PMID: 19650521 [dostęp 2017-01-15].

- ↑ E.T. Jaynes, G. Larry Bretthorst, Probability Theory: The Logic of Science, Cambridge University Press, 10 kwietnia 2003, ISBN 978-0-521-59271-0 [dostęp 2017-01-14] (ang.).

- ↑ Fisher i inni, Statistical methods for research workers., Oliver and Boyd, 1970, ISBN 0-05-002170-2.

- ↑ J. Neyman, E.S. Pearson, On the Problem of the Most Efficient Tests of Statistical Hypotheses, „Philosophical Transactions of the Royal Society of London A: Mathematical, Physical and Engineering Sciences”, 231 (694-706), 1933, s. 289–337, DOI: 10.1098/rsta.1933.0009, ISSN 1364-503X [dostęp 2017-01-14] (ang.).

- ↑ a b c Raymond Hubbard i inni, Confusion over Measures of Evidence (p's) versus Errors (α's) in Classical Statistical Testing, „The American Statistician”, 57 (3), 2003, s. 171–182 [dostęp 2017-01-15].

- ↑ Gerd Gigerenzer, The superego, the ego, and the id in statistical reasoning, [w:] Gideon Keren, Charles Lewis, A Handbook for Data Analysis in the Behaviorial Sciences: Volume 1: Methodological Issues Volume 2: Statistical Issues, Psychology Press, 14 stycznia 2014, ISBN 978-1-317-75998-0 [dostęp 2017-01-15] (ang.).

- ↑ J.P. Simmons, L.D. Nelson, U. Simonsohn, False-Positive Psychology: Undisclosed Flexibility in Data Collection and Analysis Allows Presenting Anything as Significant, „Psychological Science”, 22 (11), 2011, s. 1359–1366, DOI: 10.1177/0956797611417632 [dostęp 2017-01-15] (ang.).

- ↑ N.L. Kerr, HARKing: hypothesizing after the results are known, „Personality and Social Psychology Review: An Official Journal of the Society for Personality and Social Psychology, Inc”, 2 (3), 1998, s. 196–217, DOI: 10.1207/s15327957pspr0203_4, ISSN 1088-8683, PMID: 15647155 [dostęp 2017-01-15].

- ↑ Megan L. Head i inni, The Extent and Consequences of P-Hacking in Science, „PLOS Biology”, 13 (3), 2015, e1002106, DOI: 10.1371/journal.pbio.1002106, ISSN 1545-7885, PMID: 25768323, PMCID: PMC4359000 [dostęp 2017-01-15].

- ↑ Daniele Fanelli, “Positive” Results Increase Down the Hierarchy of the Sciences, „PLOS One”, 5 (4), 2010, e10068, DOI: 10.1371/journal.pone.0010068, ISSN 1932-6203, PMID: 20383332, PMCID: PMC2850928 [dostęp 2017-01-15].

- ↑ Daniël Lakens, On the challenges of drawing conclusions fromp-values just below 0.05, „PeerJ”, 3, 2015, DOI: 10.7717/peerj.1142, ISSN 2167-8359, PMID: 26246976, PMCID: PMC4525697 [dostęp 2017-01-15] (ang.).

- ↑ Jacob Cohen, The earth is round (p < .05): Rejoinder., „American Psychologist”, 50 (12), s. 1103–1103, DOI: 10.1037/0003-066x.50.12.1103 [dostęp 2017-01-15].

- ↑ Wilkinson i inni, Statistical methods in psychology journals: Guidelines and explanations., „American Psychologist”, 54 (8), 1999, DOI: 10.1037/0003-066X.54.8.594, ISSN 1935-990X [dostęp 2017-01-15].

- ↑ R.A. Fisher, The design of experiments., Hafner Press, 1974, s. 14, ISBN 978-0-02-844690-5, OCLC 471778573.

- ↑ Daniël Lakens, Joe Hilgard, Janneke Staaks, On the reproducibility of meta-analyses: six practical recommendations, „BMC Psychology”, 4, 2016, s. 24, DOI: 10.1186/s40359-016-0126-3, ISSN 2050-7283, PMID: 27241618, PMCID: PMC4886411 [dostęp 2017-01-15].

- ↑ J. Neyman, E.S. Pearson, On the Use and Interpretation of Certain Test Criteria for Purposes of Statistical Inference: Part I, „Biometrika”, 1/2, 1928, s. 175–240, DOI: 10.2307/2331945, JSTOR: 2331945 [dostęp 2017-01-08].